L'IA è la tecnologia che definisce la prossima generazione di computing. Negli ultimi mesi abbiamo visto come l'esplosione dell'IA generativa e degli LLM stia rivoluzionando il modo in cui interagiamo con la tecnologia e stia aumentando in modo significativo la domanda di elaborazione ad alte prestazioni nei data center, con le GPU al centro.

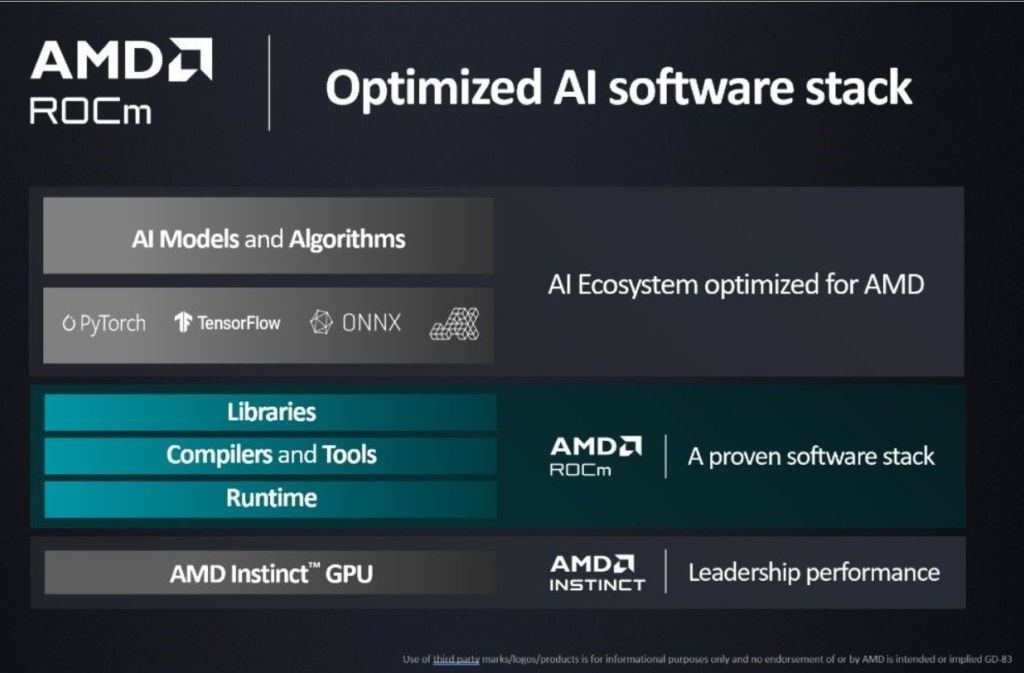

ROCm è una piattaforma software aperta che consente ai ricercatori di sfruttare la potenza degli acceleratori AMD Instinct, promuovendo la portabilità dell'innovazione HPC e AI tra le varie piattaforme. ROCm 5 presenta una suite completa di ottimizzazioni per i carichi di lavoro AI e HPC. Queste includono kernel ottimizzati per modelli linguistici di grandi dimensioni, supporto per nuovi tipi di dati e supporto per nuove tecnologie come il linguaggio di programmazione OpenAI Triton.

La convalida di ROCm comprende ora centinaia di migliaia di test del framework ogni notte e la convalida di migliaia di modelli e operatori. Questo include il supporto di framework leader come PyTorch, TensorFlow, ONNX e JAX, consentendo un'esperienza di sviluppo ottimale per tutti i modelli di intelligenza artificiale costruiti su questi framework.

ROCm 5.6 ha potenziato le funzionalità con nuovi add-on software di IA per modelli linguistici (e di altro tipo) di grandi dimensioni, comprese molte ottimizzazioni delle prestazioni in tutto il portafoglio di librerie ROCm. Inoltre, riflette i continui miglioramenti a sostegno della comunità AI, tra cui:

- l'integrazione della suite di test unitari Hugging Face nella QA di ROCm

- supporto incrementale per OpenAI Triton in modalità induttore di PyTorch 2.0

- supporto alla comunità più ampia per abilitare il supporto di OpenXLA attraverso ROCm per PyTorch, TensorFlow e JAX.

ROCm 5.6 introduce anche miglioramenti a diverse librerie matematiche come FFT, BLAS e solutori che costituiscono la base delle applicazioni HPC e miglioramenti agli strumenti di sviluppo e distribuzione di ROCm, tra cui install, ROCgdb (il debugger integrato CPU-GPU), ROCm profiler e documentazioni.

Poiché il settore si sta muovendo verso un ecosistema aperto che supporta un'ampia gamma di acceleratori, continueremo a impegnarci per ottimizzare ulteriormente i framework e i compilatori backend per ottenere prestazioni ottimali, compresi i miglioramenti dell'infrastruttura MLIR, alla base del supporto AMD per i compilatori OpenAI Triton e OpenXLA. Continueremo inoltre ad aggiungere ulteriori modelli di IA open-source ottimizzati per le soluzioni AMD nell'hub AMD su Hugging Face.

Per i nostri utenti HPC, abbiamo recentemente pubblicato una serie di ricette di pubblicazione su AMD Infinity Hub per consentire ai clienti di creare contenitori di applicazioni HPC e le future release di ROCm aggiungeranno un numero maggiore di applicazioni HPC supportate dalle soluzioni AMD Instinct.

Abbiamo inoltre riscontrato un enorme interesse da parte degli sviluppatori che desiderano eseguire la piattaforma software aperta ROCm per l'AI e il ML sulle nostre GPU per workstation Radeon consumer e Radeon Pro e abbiamo ascoltato le sfide della comunità con problemi di driver specifici su GPU non supportate. Sono lieto di annunciare che abbiamo risolto i problemi segnalati in ROCm 5.6 e ci impegniamo ad ampliare il nostro supporto in futuro.

Abbiamo in programma di espandere il supporto di ROCm dalle GPU per workstation AMD RDNA 2 attualmente supportate: Radeon Pro v620 e w6800 a selezionate GPU AMD RDNA 3 per workstation e consumatori. Il supporto formale per le GPU basate su RDNA 3 su Linux è previsto per questo autunno, a partire dalla Radeon PRO W7900 da 48 GB e dalla Radeon RX 7900 XTX da 24 GB, con ulteriori schede e funzionalità estese che verranno rilasciate nel tempo.